虽然已经多次遇到KL散度,并通过查资料进行理解,但过一段时间又忘了,最后发现写下来才是记忆的最好方式。

Continue reading

虽然已经多次遇到KL散度,并通过查资料进行理解,但过一段时间又忘了,最后发现写下来才是记忆的最好方式。

Continue reading

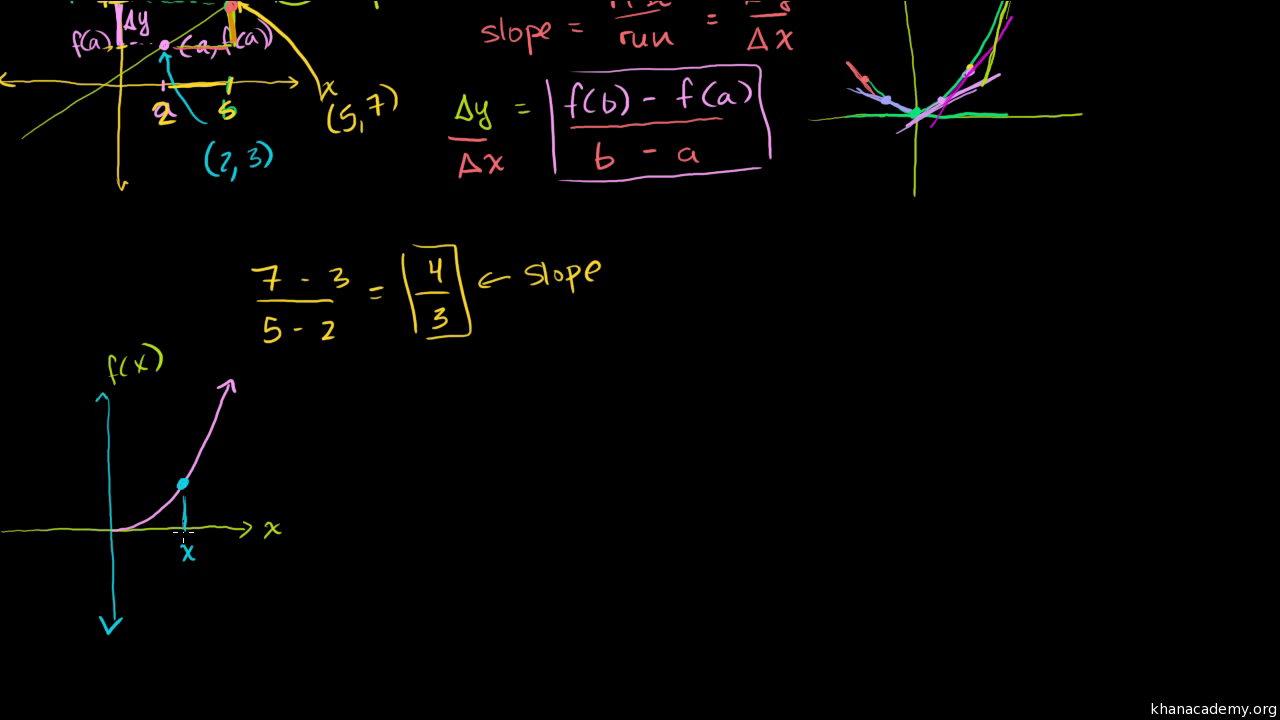

损失函数作为优化一个神经网络的目标,对于神经网络最后的性能影响重大。Softmax+crossentropy作为一个分类的损失函数受到大家广泛的使用。本文将对于softmax做一个推导,并对很多论文中对softmax所做的改进做一个总结。

Continue reading

突然对于GMM和FA好像又想清楚了一些东西,赶紧记下。

Continue reading

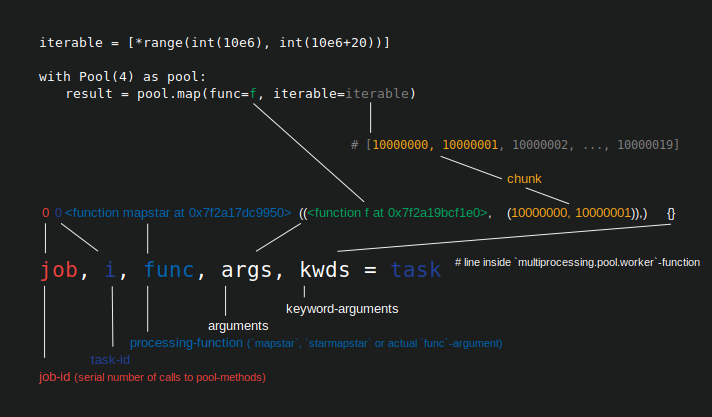

前段时间,由于自己偶遇了一个关于pytorch dataset的bug,便顺便把pytorch dataloader的源码看了下,以了解pytorch dataloader并行读数据的原理。(本来不想做什么笔记来着,恰好今天闲来无事,就记一下吧)

Continue reading

在自己看的众多说话人识别的论文中,不同的研究者为了达到intra-speaker距离最小化和inter-speaker距离最大化提出了众多的loss。虽然自己也无法记全都有哪些,但在这里先记起来,以后看到新的再做更新。

Continue reading

前段时间自己在跑代码的时候,一直被IO读的太慢的问题所烦恼。于是乎,就顺便了解了下python多进/线程的实现和原理。

Continue reading

自己在阅读这篇论文的时候,觉得这里面有很多有趣的观点。记录下来,希望能对自己以后的实验有所启发

Continue reading

最近因为要使用LSTM,所以就临时学了下RNN、LSTM和GRU以及LSTM和GRU的初始化问题,并在这里总结一下。

Continue reading

最近想复现这篇论文,顺便把论文阅读笔记和复习的新的记录一下

Continue reading

TDNN在序列建模领域好像已经出现很久了,但自己之前一直没有了解,这篇博文只对文中TDNN的部分做以记录和理解,全文的内容还请移步原文。

Continue reading

No hurry

author.job